Pri čakanju na rezultate moramo biti potrpežljivi

Torej, ob doslednem upoštevanju vseh zakonov posameznega algoritma, se mora pozicija spletne strani v iskalniku začeti dvigovati. Če si niste prebrali uvoda, ga preberite tukaj. V prejšnjem prispevku smo pisali bolj o golih osnovah in kako je bilo prej, zdaj pa si je potrebno vzeti več časa. Našteli bomo nekaj ključnih vplivov zakaj:

Načrtovanje

V izogib kaznovanja s strani iskalnega algoritma, promocijskih vsebin za določeno spletno stran ne smemo več na splet objavljati hkrati na isti dan, če ne jo lahko algoritem lahko označi kot nezaželjeno, ‘spamersko’ spletno stran brez dodane vrednosti. Da se učinek optimizacije zagotovo pokaže kot pozitiven, se morajo povezave do vaše spletne strani dodajati postopoma v določenem naključnem časovnem intervalu. Za nekoč enak pozitiven efekt, ki se je lahko zgodil že v dveh tednih, danes hitro minejo 3 meseci, za težje ključne besede oziroma besede, kjer je večja nasičenost konkurence, pa se težko pogovarjamo izpod pol leta, še raje leto dni.

Vse naše vsebine, ki jih dodajamo na splet, mora obiskati in zabeležiti tudi iskalnik v katerem se želimo pojavljati. Vsak algoritem deluje na osnovi podatkov, ki jih prebere na spletni strani, ki jo obiščejo iskalnikovi t.i. ”spletni pajki”, ki sistematično obiskujejo vse spletne strani na medmrežju in svojemu iskalniku posodabljajo bazo spletnih strani, ki jih algoritem nato razvršča.

Temu pravimo ‘cache’ ali neke vrste predpomnilnik. Če želimo, da ima optimizacija učinek, morajo biti naše vsebine indeksirane v iskalnikovem ‘cache-ju’. Če vsebine ni zabeležene v iskalnikovem predpomnilniku, zanj ta vsebina v bistvu ne obstaja. Podatke, ki se nabirajo v ‘cache-ju’, algoritem uporablja kot referenco pri določanju ustreznosti spletne strani. Kljub temu, da spletni pajki vsak dan skušajo prečesati vse spletne strani, tega ne zmorejo. In preden iskalnik dojame, da je bila nekje na neki strani sprememba, lahko mine precej časa. In vse to vpliva tudi na načrtovanje optimizacije. Lahko imamo dvajset kvalitetnih spletnih mest preko katerih promoviramo našo spletno stran, vendar, če bomo na vseh 20 hkrati dodali povezavo, jo bo iskalnik kaj hitro prepoznal kot ‘spam’. Da do tega ne pride, moramo našo promocijo skrbno načrtovati. Če smo prej lahko dodali vse linke praktično hkrati, moramo za enak efekt, danes te linke porazdeliti na ustrezne časovne intervale. In ker linke objavljamo z večjimi intervali, še toliko dlje traja, da iskalnikov predpomnilnik ugotovi, da je prišlo do neke spremembe v zvezi z našo stranjo, preden jo pod iskalne nize uvrsti višje.

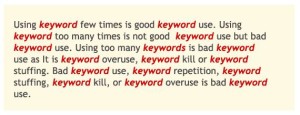

Zasičevanje s ključnimi besedami

Zasičevanje spleta s ključnimi besedami smo že omenili in včasih je bila to uveljavljena praksa, ki je delovala. Bistvo optimizacije spletnih strani je slonelo na tem, da smo do svoje strani pripeljali čim več povezav s čim več različnih kvalitetnih spletnih mest pod točno tisto ključno besedo pod katero smo med organskimi zadetki – to so tisti, ki niso plačljivi – želeli v iskalniku biti na vrhu. Iskalnik pa se je zanašal na to, da povezave, ki vključujejo ključno besedo, pod katero želimo biti v iskalniku uvrščeni visoko, predstavljajo kvalitetno spletno stran, pri čemer je bila logika iskalnika, da bolj kot je določena spletna stran razširjena med ljudmi, več povezav bodo ljudje do nje ustvarjali, ko se bodo sklicevali nanjo ali posredovali zanimivo, informativno vsebino.

Zasičevanje spleta s ključnimi besedami smo že omenili in včasih je bila to uveljavljena praksa, ki je delovala. Bistvo optimizacije spletnih strani je slonelo na tem, da smo do svoje strani pripeljali čim več povezav s čim več različnih kvalitetnih spletnih mest pod točno tisto ključno besedo pod katero smo med organskimi zadetki – to so tisti, ki niso plačljivi – želeli v iskalniku biti na vrhu. Iskalnik pa se je zanašal na to, da povezave, ki vključujejo ključno besedo, pod katero želimo biti v iskalniku uvrščeni visoko, predstavljajo kvalitetno spletno stran, pri čemer je bila logika iskalnika, da bolj kot je določena spletna stran razširjena med ljudmi, več povezav bodo ljudje do nje ustvarjali, ko se bodo sklicevali nanjo ali posredovali zanimivo, informativno vsebino.

Slednje se sklada tudi z željami iskalnikov, da bi se na spletu vse dogajalo naravno. Vse gre nekako v tej smeri, da bi se optimizacijo prisililo v promoviranje spletnih strani preko plačljivih oglasov iskalnika, na organske zadetke med rezultati pa, da bi najbolj vplivali kar uporabniki spleta preko vsakdanje uporabe interneta – ”naravno”. Vendar, naravno se lahko tudi načrtuje, zato so se morali optimizerji prilagoditi in pričeti razmišljati drugače. Kadar se za namen optimizacije dodaja nove povezave do določene spletne strani, se mora optimizer znati poistovetiti z množico ljudi, ki jih potencialno zanima vsebina strani, ki jo optimiziramo, in se pri tem zliti z njimi kot običajen uporabnik, ki ne promovira oz. optimizira spletno stran, pač pa iskreno doda povezavo do nečesa uporabnega. Torej, ni več pomembno le kam bomo povezavo dodali, pač pa tudi način, kako jo bomo dodali. Ker pri optimizaciji ni več zaželeno, da se povezave ustvarja točno na ključnih besedah, ki jim želimo dvigniti pozicijo v iskalniku, pa je potrebno zato za enak učinek, številčno gledano, ustvariti tudi več povezav. In če upoštevamo še prej omenjene določene naključne intervale dodajanja povezav, hitro vidimo, da bo zato spet potreben čas.

Kvaliteta backlinkov

Na kratko, kvantiteto vse bolj izrinja kvaliteta. Ni toliko na ogromnem številu povezav, kot je na kvaliteti teh povezav, da vodijo s čim boljše, čim bolj prepoznane spletne strani s čim višjim page rankom, s strani, ki že imajo na spletu uveljavljeno neko vrednost. Optimizerji spletnih strani morajo vedno več časa namenjati iskanju spletnih mest od koder bodo na našo stran vodile kvalitetne povezave. Torej, da več razmišljajo o tem kam bodo povezavo dali, da bo res koristila in ne škodovala. Vse več pozornosti pa je potrebno nameniti tudi predhodnem preverjanju spletne strani kamor imamo namen dati povezavo do naše strani, da ni okužena ali kako drugače kompromitirana, saj lahko takšna povezava pri iskalniku uničuje tudi ugled naše strani in nam jo bo uvrstil nižje.

Dokaj nepredvidljiv faktor so posodobitve algoritmov, ki se sicer dogajajo redno, vendar nikoli niso točno napovedani, niti ne obstajajo direktna navodila kako se uskladiti z vsakim popravkom posebej. Do zaključkov je potrebno priti praktično sam in z deljenjem izkušenj na forumih, kjer se diskutira o optimizaciji. Popravkov je sicer več vrst, eni se bolj osredotočajo na on-site ali kako morajo biti urejene same spletne strani znotraj sebe, da jih bo iskalnih prepoznal kot dobre, drugi bolj na off-site ali vrednotenje zunanjih povezav, ki vodijo do naše strani. Pravega recepta, kako vsak popravek dočakati pripravljen, pa ni. Vsakič znova je potrebno kako stvar več prilagoditi pri svojem delu, kar zopet zahteva čas. Poleg tega se popravki navadno ne zgodijo preko noči, pač pa lahko traja tudi mesec dni preden vplivajo na vse spletne strani. Medtem pa se njihov vpliv meša z vplivom, ki je plod našega dela, zato je vedno težje v vsakem trenutku točno vedeti zakaj je neka pozicija poskočila, druga pa padla. Ugotavljanje tega je lahko mučno in časovno nadvse potratno delo. Navadno popravki sicer ne vplivajo preveč drastično, a nazadnje se je zgodilo, da je popravek tako zelo premešal pozicije, da večina optimizerjev še vedno išče kam obrniti jadra, da bi ujeli veter vanje.

Odpravljanje preteklih ”grehov”

Za razliko od naših politikov, katerih grehi ne vplivajo na njihove pozicije na družbeni lestvici, kaj šele da bi bili za neko dejanje za nazaj odgovorni in kaznovani, pa algoritmi niso tako popustljivi. Včasih korektno delo, po pravilih, se danes ne sklada več z novimi pravili in nam preteklo delo lahko celo škodi. Zato je potreben konkreten generalni ”servis” povezav, ki smo jih ustvarili v preteklosti. Če smo si sproti zabeležili kam vse smo povezave dajali, potem to ne bi smela biti težava. Zopet je potreben zgolj čas, da vse popravimo. Če si povezav nismo beležili sproti pa je potrebna drugačna prilagoditev. In sicer, da naprej delamo po novih pravilih algoritma toliko časa dokler naše povezave iz preteklosti ne predstavljajo manjšinskega deleža vseh povezav, ki smo jih za določeno spletno stran dodali.

Kljub temu, da je v zadnjem času bilo precej pomislekov, ko so se ponekod na najvišja mesta uvrščale tudi popolnoma nekvalitetne spletne strani, ki po vseh pravilih tja nikakor ne bi smele biti uvrščene, pa zgornji rek še vedno velja. Kvalitetna vsebina in redno ažurirana spletna stran ima več možnosti, da jo bo iskalnik uvrstil zelo visoko med organskimi zadetki iskanj. Če si boste v osnovi vzeli dovolj časa za vsebino svoje spletne strani, boste imeli kasneje toliko manj težav z optimizacijo in posledično bodo pozitivni rezultati optimizacije tudi hitreje vidni.

Dobr napisano. Problem je, ker stranke tega velikokrat ne razumejo in rečejo, da jim je konkurenca obljubila 1. stran že po 14 dneh. Vedno recem, v redu, naj gredo tja in naj se vrnejo, ko bodo padli na 110. stran. 😉

Večina potem zelo premisli. 🙂

Evo, tle smo se o tem pogovarjali:

http://www.optimizacija-strani.info/2013/06/google-je-salabajzer/

Zelo koristen nasvet. Hvala!